Negatywne wyniki badań znikają z większości dyscyplin naukowych

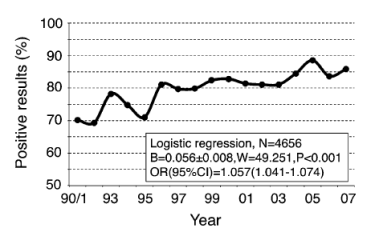

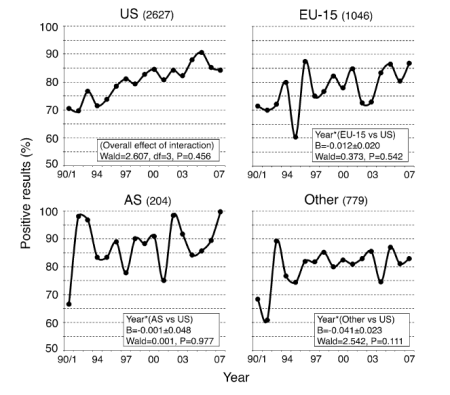

W 2012 roku na łamach czasopisma Scientometrics ukazała się analiza ponad 4 600 artykułów z różnych dyscyplin naukowych, które zostały opublikowane w latach 1990–2007. Wynika z niej, że odsetek prac z pozytywnymi wynikami (potwierdzającymi testowaną hipotezę) wynosił 70,2% w latach 1990–1991, a w roku 2007 – 85,9%[1].

Dziedziny

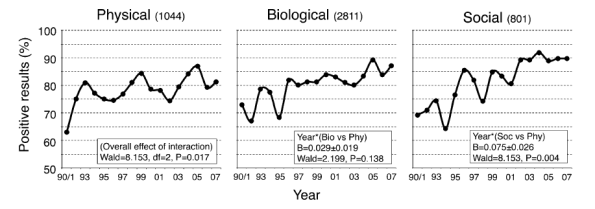

Najwięcej pozytywnych rezultatów odnotowano w naukach społecznych, na kolejnym miejscu uplasowały się nauki biologiczne, a w naukach fizycznych odnotowano najmniej pozytywnych wyników[1].

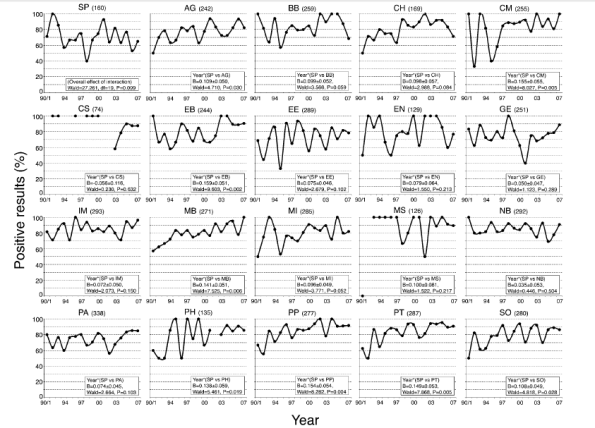

Dyscypliny

Najmniej pozytywnych rezultatów wystąpiło w naukach o kosmosie. Tylko w neurobiologii i behawiorze oraz w naukach o kosmosie nastąpił spadek pozytywnych wyników na przestrzeni lat. Nauki o Ziemi oraz nauki o zwierzętach i roślinach miały relatywnie stabilny trend (brak wzrostu) pozytywnych rezultatów, a w pozostałych dyscyplinach odnotowano ich wzrost. Największy wzrost zaobserwowano w takich dyscyplinach jak: medycyna kliniczna, farmakologia i toksykologia oraz biologia molekularna[1].

SP – nauki o kosmosie, AG – nauki rolnicze, BB – biologia i biochemia, CH – chemia, CM – medycyna kliniczna

CS – informatyka, EB – ekonomia i biznes, EE – środowisko/ekologia, EN – inżyneria, GE – nauki o Ziemi

IM – immunologia, MB – biologia molekularna i genetyka, MI – mikrobiologia, MS – badania materiałowe, NB – neurobiologia i behawior

PA – nauki o roślinach i zwierzętach, PH – fizyka, PP – psychiatria/psychologia, PT – farmakologia i toksykologia, SO – nauki społeczne ogółem

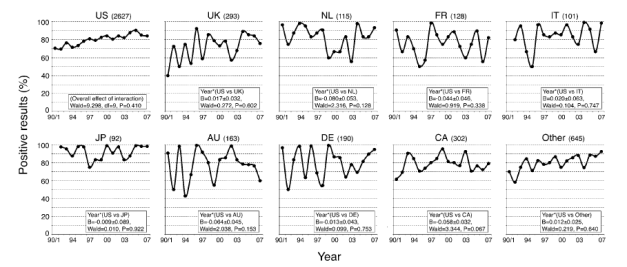

Państwa

Autorzy z USA opublikowali mniej pozytywnych wyników od autorów z państw azjatyckich (zwłaszcza Japonii), ale więcej od autorów z Europy (zwłaszcza Wielkiej Brytanii)[1].

US – USA, UK – Wielka Brytania, NL – Holandia, IT – Włochy

JP – Japonia, AU – Australia, DE – Niemcy, CA – Kanada

US – USA; EU-15 – Austria, Belgia, Dania, Finlandia, Francja, Niemcy, Grecja, Irlandia, Włochy, Holandia, Portugalia, Hiszpania, Szwecja, Wielka Brytania

AS – Chiny, Hong Kong, Indie, Japonia, Singapur, Korea Południowa, Tajwan

Przyczyny

Jakie mogą być przyczyny takiego stanu rzeczy?

- Testowane hipotezy mogą w coraz większym stopniu okazywać się prawdziwe. Oczywiście, nie dlatego, że nauka jest bliższa prawdy dzisiaj niż 20 lat temu, tylko dlatego, że naukowcy mogą stawiać hipotezy, które częściej są potwierdzane, aby uzyskać wyniki, które łatwiej jest opublikować[1].

- Średnia moc statystyczna badań mogła wzrosnąć, np. dzięki wzrostowi średniej wielkości badanych prób, co zwiększyło szansę na odkrycie prawdziwych relacji. Byłaby to dobra wiadomość, gdyż oznaczałaby, że jakość metodologiczna badań się poprawiła. Niestety, moc statystyczna badań zdaje się być bardzo niska we wszystkich dyscyplinach i nie ma dowodów na to, że wzrosła na przestrzeni lat[1].

- Negatywne wyniki mogą być rzadziej wysyłane i akceptowane do publikacji albo w jakiś sposób są zamieniane w pozytywne rezultaty przez reinterpretację, reanalizę, selekcję lub inne formy manipulacji/fabrykacji[1]. We wcześniejszych analizach wykazano, że negatywne wyniki są rzadziej publikowane i cytowane[2][3].

Skutki

System, który dyskwalifikuje negatywne wyniki, nie tylko bezpośrednio wypacza literaturę naukową, ale może także zniechęcać do projektów wysokiego ryzyka i wywierać presję na naukowców, by fabrykowali i fałszowali swoje dane.

[…]

Jednym z najbardziej niepokojących wypaczeń wiedzy naukowej jest utrata negatywnych danych. Wyniki, które nie potwierdzają oczekiwań – ponieważ dają one efekt, który albo nie jest istotny statystyczne, albo przeczy hipotezie – mają kluczowe znaczenie dla postępu naukowego, ponieważ ten ostatni jest możliwy tylko przez zbiorowy, samokorygujący się proces. Tymczasem niedobór wyników zerowych i negatywnych został zaobserwowany na niezliczonych polach badawczych. Ich brak w literaturze nie tylko przeszacowuje wielkość efektu w metaanalizach, co wyolbrzymia znaczenie zjawisk, ale może również powodować marnotrawstwo zasobów na powtarzanie badań, które się nieudały, a nawet otwierać nowe pola badawcze w oparciu o całkowicie nieistniejące zjawiska[1].

Przypisy:

- Fanelli D (2012), „Negative results are disappearing from most disciplines and countries”, Scientometrics, 90 (3), 891–904. DOI: 10.1007/s11192-011-0494-7.

- Dwan et al (2008), „Systematic Review of the Empirical Evidence of Study Publication Bias and Outcome Reporting Bias”, PLoS One, 3 (8), e3081. PMID: 18769481.

- Fanelli D (2010), „Do Pressures to Publish Increase Scientists’ Bias? An Empirical Support from US States Data”, PLoS One, 5 (4), e10271. PMID: 20422014.